Arize Phoenix 101 AI LLM 评估:调试入门

·1 min

什么是 arize-phoenix #

Arize Phoenix 是一个开源的可观测性 (Observability) 库,专为大语言模型 (LLM) 应用的实验、评估和故障排除而设计。它可以帮助 AI 工程师和数据科学家监测 LLM 的行为、分析模型性能、可视化请求流,并追踪问题以优化 AI 相关应用。此外,Phoenix 还支持数据可视化和性能评估,便于改进和优化模型。

安装 arize-phoenix 环境 #

首先,使用 pip 安装 arize-phoenix 及相关依赖项:

pip install arize-phoenix

pip install -q openinference-instrumentation-openai openai

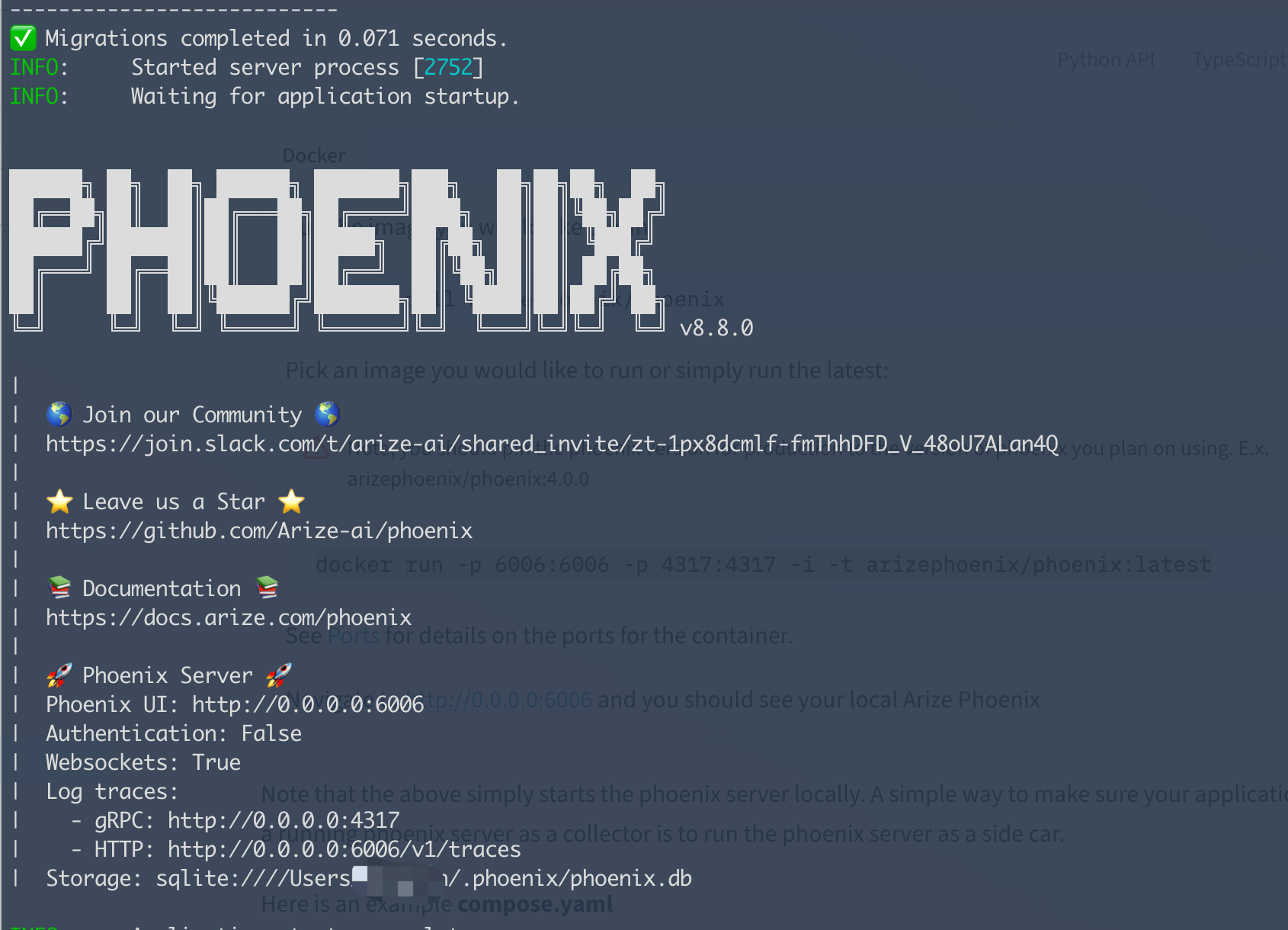

安装完成后,可以运行以下命令启动 Phoenix 服务器:

phoenix serve

运行后,你可以在 http://localhost:6006 访问 Phoenix 的 UI 界面。

代码示例 #

python

以下是一个使用 arize-phoenix 进行 LLM 监控的示例:

import os

from phoenix.otel import register

import openai

from openinference.instrumentation.openai import OpenAIInstrumentor

# 注册 OpenTelemetry Tracer Provider

tracer_provider = register(

project_name="your-next-llm-project1",

endpoint="http://localhost:6006/v1/traces"

)

# 启用 OpenAI 监控

OpenAIInstrumentor().instrument(tracer_provider=tracer_provider)

os.environ["OPENAI_API_KEY"] = "YOUR OPENAI API KEY"

# client = openai.OpenAI()

# 创建 OpenAI 客户端,使用 OpenRouter 代理,

# 当然这里可以用DeepSeek

client = openai.OpenAI(

base_url="https://openrouter.ai/api/v1",

)

# 发送请求并打印回复

response = client.chat.completions.create(

model="gpt-4o-mini",

messages=[{"role": "user", "content": "Write a haiku."}],

)

print(response.choices[0].message.content)

运行效果

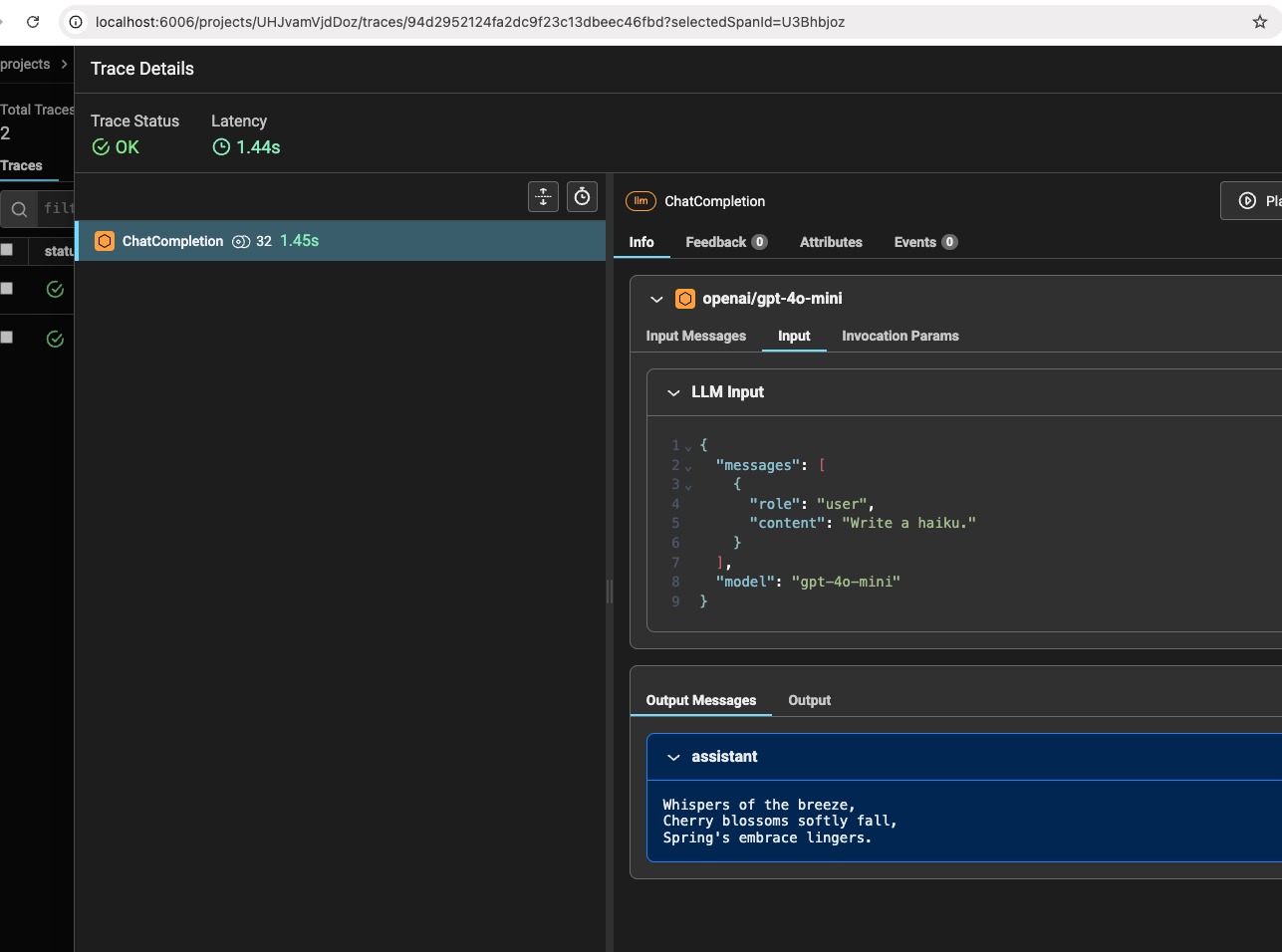

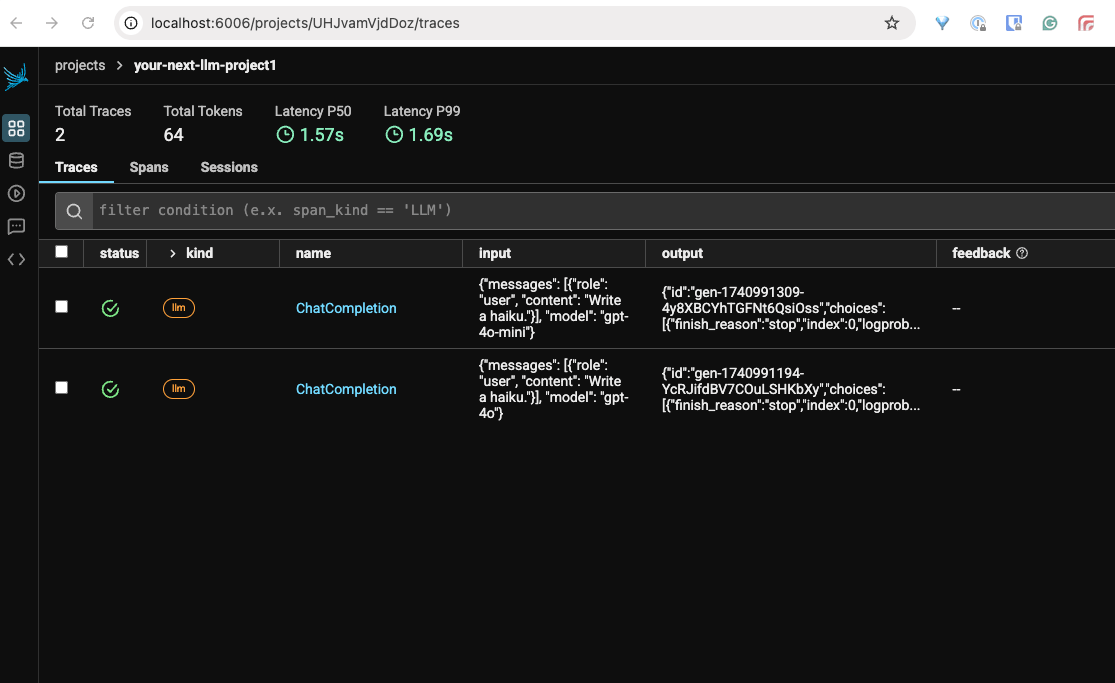

运行上述代码后,你可以在 Phoenix UI 界面查看 LLM 请求的日志和可视化数据,如下图所示:

结论 #

Arize Phoenix 提供了一个强大的 LLM 可观测性解决方案,使开发者能够更轻松地监控和调试 LLM 应用。通过结合 OpenTelemetry,它可以帮助团队优化 API 请求,分析模型性能,并提高 AI 系统的透明度。如果你正在构建 LLM 相关的应用,Arize Phoenix 是一个值得尝试的工具!